- Rubin no es un chip más: es una nueva forma de diseñar, escalar y pagar la inteligencia artificial.

- NVIDIA está atacando el mayor problema de la IA moderna: el costo y la complejidad de operar modelos a gran escala.

- El anuncio en CES 2026 marca un cambio estructural en la infraestructura que sostiene la economía digital.

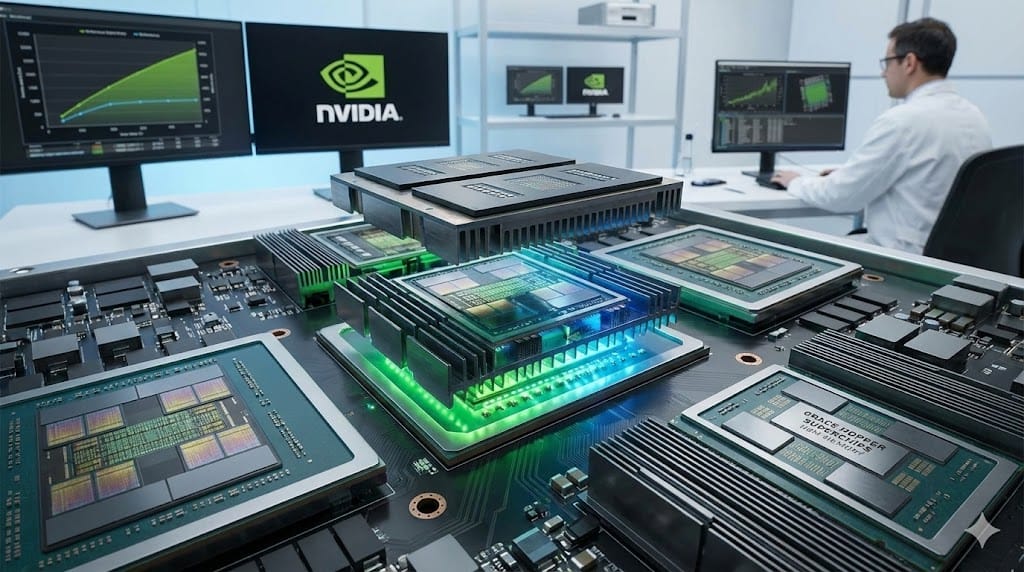

Durante la Consumer Electronics Show (CES) 2026, Jensen Huang, CEO de NVIDIA, confirmó un hito crucial: la nueva plataforma Vera Rubin, compuesta por seis chips de alto rendimiento enfocados en inteligencia artificial, ya se encuentra en producción completa y promete cambios estructurales en la infraestructura de IA global.

Este anuncio va más allá del tradicional "chip más rápido": NVIDIA está redefiniendo cómo se entrena, escala y despliega la inteligencia artificial en el mundo moderno. Aquí te explicamos lo que importa realmente, tanto para la industria como para empresas, desarrolladores y gobiernos, y lo que otros medios aún no han articulado con perspectiva estratégica y profunda.

Explora más análisis sobre innovación, plataformas tecnológicas y el impacto real de la IA en Adtech.

1. Rubin no es solo un chip, es una nueva arquitectura para IA en masa

La plataforma Vera Rubin no es un único procesador, sino un sistema co-diseñado de seis componentes: la GPU Rubin, la CPU Vera, conmutadores NVLink 6, SuperNIC ConnectX-9, DPU Bluefield-4 y switches Ethernet Spectrum-6. Esta co-ingeniería elimina cuellos de botella clásicos en centros de datos al integrar cómputo, red y almacenamiento en un solo ecosistema.

Este acercamiento, conocido como extreme codesign, reduce el costo de generar “tokens” de IA (las unidades básicas de salida en modelos de lenguaje) a una décima parte en comparación con la generación anterior (Blackwell).

¿Por qué es relevante?

Porque baja drásticamente el gasto operativo en IA de gran escala, algo que hasta ahora ha sido uno de los mayores frenos para empresas y startups que quieren competir con los gigantes tecnológicos.

2. Más potencia, menos recursos: ahorro de costes real

Los datos técnicos que NVIDIA ha resaltado, sugieren que Rubin puede ofrecer:

- Hasta 5× más capacidad de inferencia frente a generaciones previas.

- Hasta 3.5× más rendimiento en entrenamiento intensivo.

- Reducción significativa en la cantidad de chips necesarios para tareas complejas.

Esto no es solo una mejora incremental: es un cambio de paradigma que afecta directamente los costos de operación de servicios basados en IA.

Esta mejora no solo significa “IA más rápida”, sino IA que es económicamente más sostenible de escalar, un factor crítico para la adopción empresarial fuera de los gigantes de Silicon Valley.

3. Impacto en la infraestructura global de IA

La plataforma Rubin ya está siendo probada por grandes proveedores en la nube, e integra tecnologías de red y almacenamiento propias que aceleran la comunicación entre nodos.

Esto tiene varias implicaciones estratégicas:

- Mayor adopción de supercomputación AI en la nube: servicios como Microsoft Azure, AWS y otros están planeando integrarla.

- Reducción de barreras de entrada para modelos complejos: economías de escala pueden hacer viable el entrenamiento de modelos de razonamiento y multimodales para organizaciones medianas.

- Competencia más intensa en hardware especializado: rivales como AMD, Google y Qualcomm están acelerando sus propias arquitecturas para mantenerse relevantes.

4. Más allá del rendimiento: hacia IA física y reasoning

Uno de los elementos más importantes que la mayoría de medios técnicos minimizan es que NVIDIA no solo presentó chips: presentó un ecosistema de inteligencia artificial que integra capacidades “reasoning” (razonamiento) y aplicaciones físicas integradas.

Esto incluye:

- Modelos y herramientas de IA física (robots, simulación y entornos reales).

- Sistemas de almacenamiento “native AI” que mejoran el rendimiento de conversaciones extensas y contextos largos.

- Arquitecturas pensadas para soportar modelos autónomos que aprenden y actúan en tiempo real.

5. Contexto de mercado: un liderazgo que debe defenderse

Aunque NVIDIA domina gran parte del mercado de GPUs para IA, el panorama es cada vez más competitivo:

- Qualcomm lanzó chips AI con foco en eficiencia energética que compiten por nichos emergentes.

- Google impulsa sus propias unidades tensoriales (TPU) para IA en la nube, reduciendo dependencia de proveedores externos.

La producción temprana y el diseño completo de Rubin son, en parte, una respuesta estratégica a este entorno competitivo: NVIDIA busca asegurar su posición no solo por rendimiento, sino por integración, costo y ecosistema completo de herramientas integradas.

6. Limitaciones y desafíos reales que pocos analistas mencionan

Aunque la producción está en marcha, expertos señalan que:

- La disponibilidad masiva en centros de datos tardará meses en materializarse.

- La transición a nueva infraestructura requiere software optimizado, sin lo cual los beneficios de hardware pueden diluirse.

- Las demandas de memoria avanzada y sistemas de enfriamiento especializados son aún cuellos de botella para muchos datacenters existentes.